注意力机制直观展示

*** 次数:1999998 已用完,请联系开发者***

大模型的注意力机制给我们的启示通过探索AI如何模仿人脑来提高效率和学习速度,我们可以更好地理解人类的注意力如何在信息泛滥的世界中受到挑战,并找到强化自身专注力的方法。开始一个系列,智能时代的变革与思考大模型的注意力机制给我们的启示大模型的核心:注意力机制现在的大模型比上一代更加智能,上一...

(`▽′)

长光卫星申请一种基于注意力机制和LSTM的CMOS航天相机温度噪声...金融界2024年7月28日消息,天眼查知识产权信息显示,长光卫星技术股份有限公司申请一项名为“一种基于注意力机制和LSTM的CMOS航天相机温度噪声校正方法“,公开号CN202410566500.5,申请日期为2024年5月。专利摘要显示,一种基于注意力机制和LSTM的CMOS航天相机温度...

长城信息申请基于注意力机制改进YOLOv5的人脸检测方法及系统专利,...金融界2024年7月19日消息,天眼查知识产权信息显示,长城信息股份有限公司申请一项名为“基于注意力机制改进YOLOv5的人脸检测方法及系统“,公开号 CN202410776303.6 ,申请日期为2024年6月。专利摘要显示,本发明涉及基于注意力机制改进YOLOv5的人脸检测方法及系统,方法...

(°ο°)

深城交获得发明专利授权:“基于注意力机制优化的轻量化车辆车牌...证券之星消息,根据企查查数据显示深城交(301091)新获得一项发明专利授权,专利名为“基于注意力机制优化的轻量化车辆车牌颜色识别方法”,专利申请号为CN202311694289.7,授权日为2024年6月18日。专利摘要:本发明提出基于注意力机制优化的轻量化车辆车牌颜色识别方法,属于...

>▂<

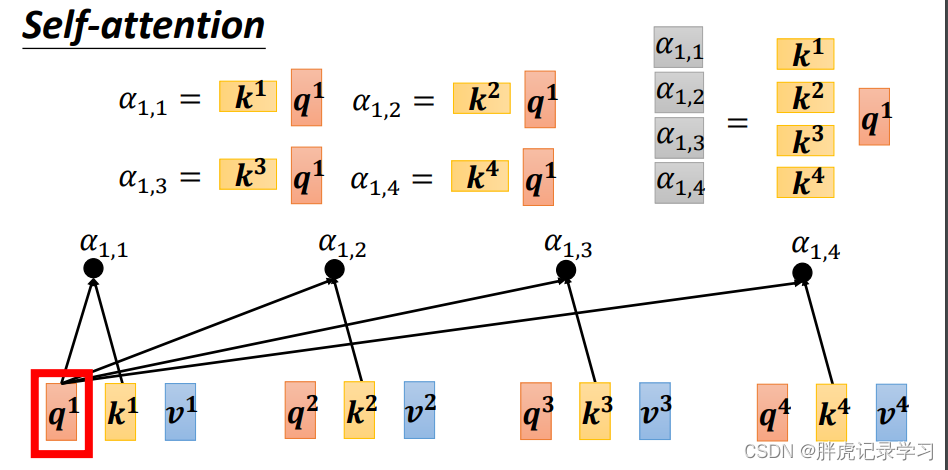

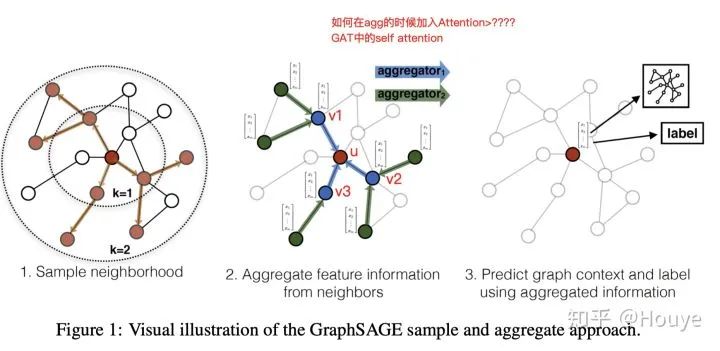

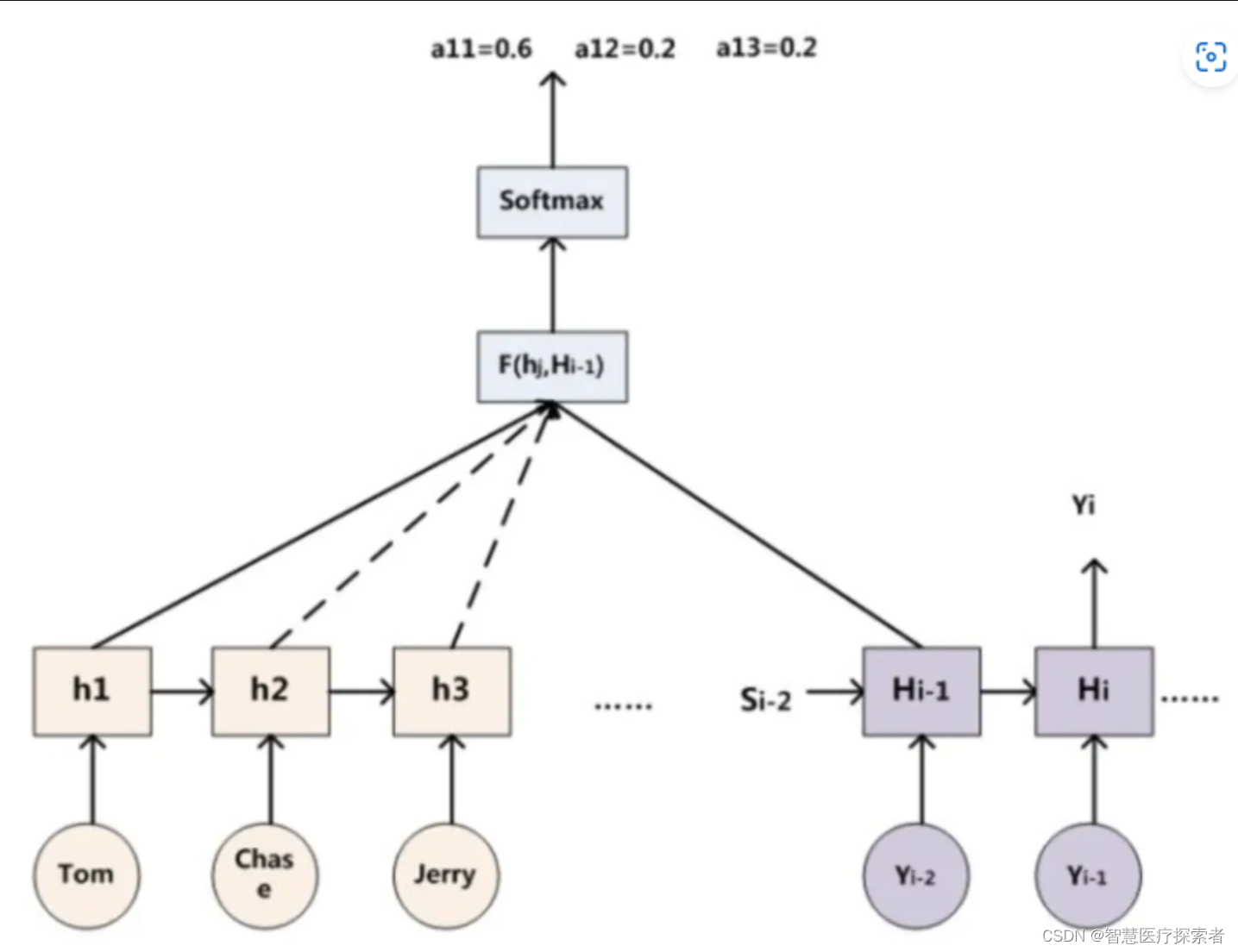

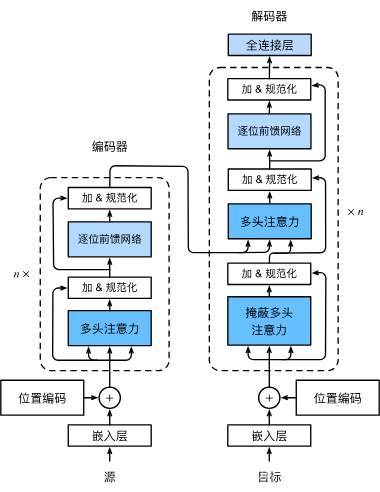

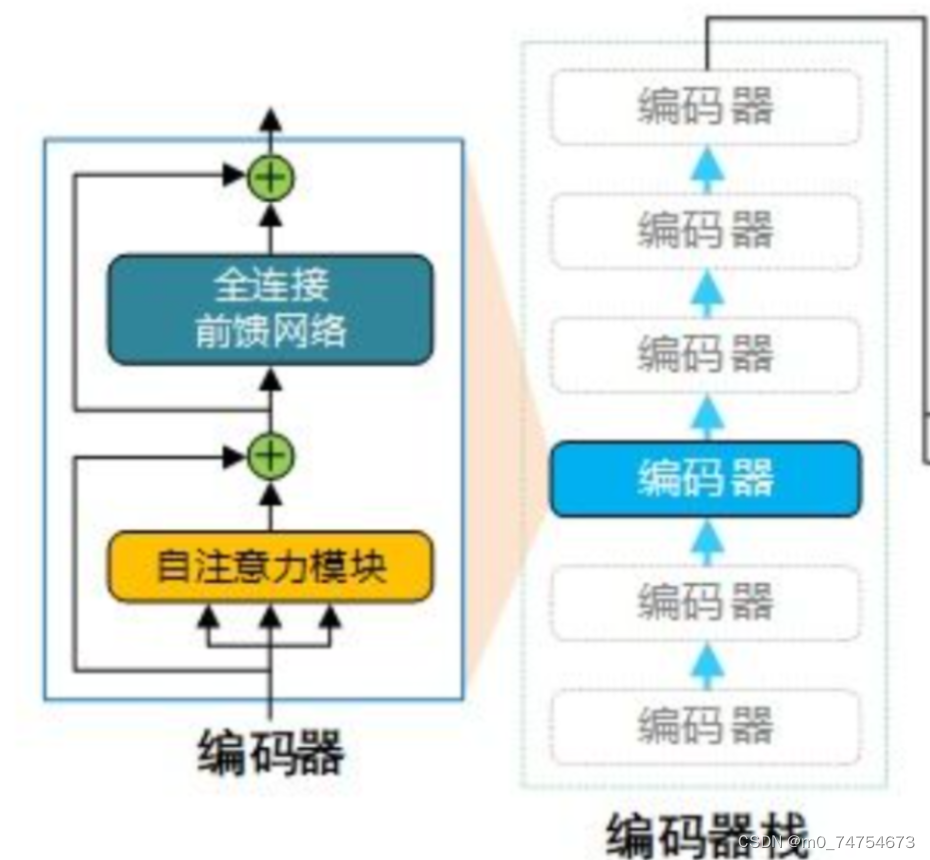

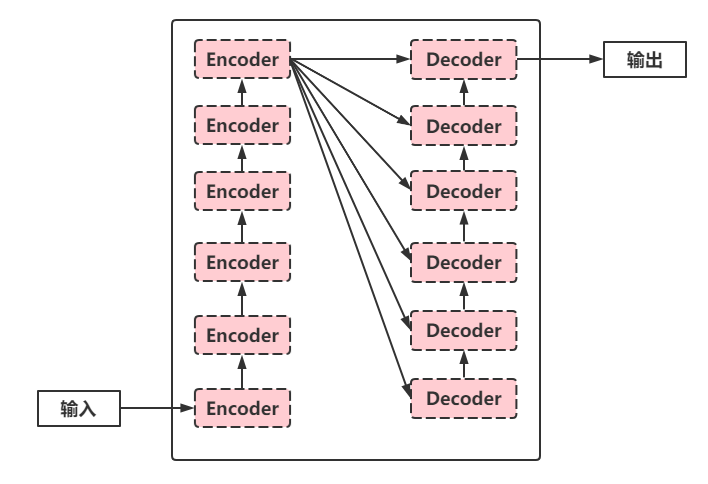

AI绘画中,Transformer的“自注意力机制”有什么作用?Transformer是一种革命性的自然语言处理(NLP)模型,它使得机器能够更好地理解和生成人类语言。你可以把Transformer看作是一个高级的翻译官,不仅能在不同语言之间进行翻译,还能从文本中提取有用的信息,以回答问题、生成摘要等。Transformer的核心原理在于“自注意力机制”和...

算法人生(20):从“自注意力机制”看“个人精力怎么管”在之前的文章中,我们用了不少互联网领域的模型、方法解决我们的工作、生活中的一些问题,都很有效。这篇文章,我们从生成式AI的构成原理,看看能不能借鉴应用到精力管理上。我们知道在ChatGPT中,Transformer模型扮演着重要的角色。Transformer 模型通过自注意力机制来建模序列...

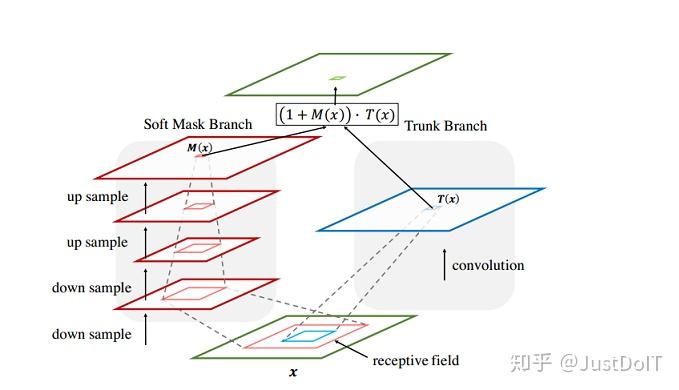

功耗毫瓦级 基于注意力机制的类脑芯片问世展示了类脑神经形态计算在融合高抽象层次大脑机制时的天然优势,相关研究在线发表于《自然·通讯》。该研究提出了“神经形态动态计算”的概念,设计了一种类脑神经形态芯片“Speck”,来实现基于注意力机制的动态计算。该芯片在硬件层面做到“没有输入,没有功耗”,在算法层...

超聚变FusionOne AI单机跑满血DeepSeek,吞吐性能飙升60%如今,人工智能发展迅猛,大模型更是成为推动AI技术进步的“引擎”。然而,随着模型参数量的激增,算力需求也呈指数级增长,如何高效、低成本地运行大模型成为行业面临的共同挑战。以DeepSeek R1满血大模型为例,其参数量高达6710亿,由于其采用了前沿的MLA注意力机制、共享专...

清华大学申请多尺度多模态深度注意力网络专利,能高效获取三维医学...本发明公开了基于多尺度多模态深度注意力网络的训练方法及系统,该方法,包括采用自监督学习算法进行训练,利用深度神经网络和注意力机制,从多种尺度联合分析多种模态数据内部的分布特性以及多种模态数据之间的关联性,无需任何人工标注,即可自动提取出含有丰富的语义信息的影...

ICML2024高分!魔改注意力,让小模型能打两倍大的模型彩云科技团队 投稿量子位 | 公众号 QbitAI改进Transformer核心机制注意力,让小模型能打两倍大的模型!ICML 2024高分论文,彩云科技团队构建DCFormer框架,替换Transformer核心组件多头注意力模块(MHA),提出可动态组合的多头注意力(DCMHA)。DCMHA解除了MHA注意力头的查找...

evo加速器部分文章、数据、图片来自互联网,一切版权均归源网站或源作者所有。

如果侵犯了你的权益请来信告知删除。邮箱:xxxxxxx@qq.com